Ein Gast-Beitrag von Björn Lockstein, Geschäftsführer Kreation bei der auf Retail-Kommunikation spezialisierten Agentur IMPLIZIT GmbH.

Ja, wir geben es zu: Wir testen gern! Nicht weil wir etwa unsicher sind. Sondern weil wir sicher sind, dass wir so zu erfolgreicheren Ergebnissen für unsere Kunden kommen.

Normalerweise meidet die Kreation die Marktforschung wie der Teufel das Weihwasser. Denn kaum ist die Idee da, wird sie gleich wieder automatisch von der Mafo vom Tisch gewischt. Dieses sich hartnäckig haltende Vorurteil möchten wir jetzt selber vom Tisch wischen. Natürlich mit einem Test.

Gemeinsam mit MediaAnalyzer wollten wir herausfinden welches der beiden von uns entwickelten Displays für unseren Kunden GlaxoSmithKline den Abverkauf am stärksten positiv beeinflusst. Jedes Display hatte seine Stärken und es war rational nicht mehr zu begründen warum man das eine dem anderen vorziehen sollte. Und auch das Bauchgefühl stand vor einer Pattsituation. In solchen Fällen kann man eine Münze werfen oder testen.

Abb.: Die beiden Aufsteller im Vergleich

Wir entschieden uns für Letzteres. MediaAnalyzer entwickelte daraufhin ein Testdesign, in welchem sie mehrere Test-Tools miteinander kombinierten. Ziel war es den „Sieger“ herauszufinden und auch Erkenntnisse bezüglich des „Warum“ zu gewinnen. Statt einer Balken- und Tortendiagramm-Schlacht am Ende wollten wir lieber konkrete Ergebnisse generieren, die uns schnell und unkompliziert einen echten Wissens-Mehrwert bieten.

Der Test wurde online durchgeführt und ermöglichte so eine hohe Zahl an Probanden bei zugleich niedrigen Kosten. In einem simulierten „Einkaufsbummel“ durchlief jeder Proband verschiedene Läden, die er auch in Wirklichkeit an einem durchschnittlichen Einkaufstag besuchen würde. In unserem Fall entschieden wir uns für eine Drogerie, einen Supermarkt, einen Getränkemarkt und natürlich eine Apotheke. Von jedem Geschäft gab es drei Raum-Ansichten und eine typische Regalansicht mit einer bestimmten Warenkategorie. Um Verzerrungen vorzubeugen, integrierten wir in jedem Laden auf je einer Ansicht ein passendes Display. So konnten die Teilnehmer nicht wissen, um welches Produkt es in dem Test ging.

Vereinfacht dargestellt lief der Test wie folgt ab:

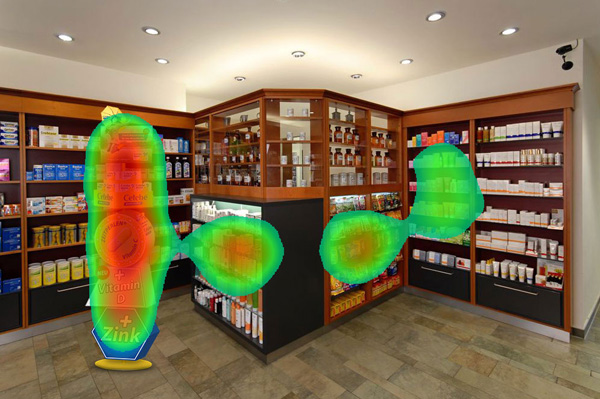

Nach einer anfänglichen Befragung zur Person wurde der Proband aufgefordert sich aus vielen verschiedenen Produkten einen Warenkorb zusammenzustellen. Danach ging es weiter zum „Shop-Walk“, der ihn durch die verschiedenen Geschäfte führte. Mithilfe von AttentionTracking™ konnten wir auf jedem Bild die Blicke des Probanden verfolgen und so seine Aufmerksamkeit messen. Wir erhielten wertvolle Informationen, was den Blick als erstes, zweites, drittes anzog und auch wie schnell die Aufmerksamkeit von unserem Display generiert wurde. Neben dem Blickverlauf wurde zudem gemessen, wie lange der Proband jedes Display betrachtete. Dies ist für uns ein wichtiger Anhaltspunkt dafür, wie viele Informationen auf dem Display untergebracht werden sollten.

Abb.: Die Heatmap zeigt die Aufmerksamkeitsverteilung

Um den Uplift zu messen mussten die Probanden zum Schluss erneut einen Warenkorb zusammenstellen, so dass wir diesen mit dem ersten Korb vergleichen konnten. Hinzu kamen noch explizite Fragen bezüglich der Auffälligkeit, der Emotionalität, des Brand Image und der Aktivierung.

Es wurde in drei Gruppen (Display A, Display B, kein Display) getestet, so dass wir die Ergebnisse sehr gut miteinander vergleichen konnten. Der Zeitraum vom Testaufbau bis zu den Ergebnissen betrug nicht einmal zwei Wochen. Die Ergebnisse halfen uns den „Sieger“ schnell zu ermitteln und weitere Verbesserungspotentiale aufzudecken. Die zusätzlich gewonnen Erkenntnisse helfen uns zudem in Zukunft bei unserer Arbeit und wir starten beim nächsten Display bereits auf einem höheren Niveau.

Jetzt sind wir natürlich sehr gespannt darauf, wie sich das Display in der Realität bewährt und wie stark die Korrelation mit den Ergebnissen aus dem Test ausfällt.

Ein sehr interessanter Artikel. Vielen Dank.

Schön wäre es, wenn Sie dann auch den Vergleich mit den aus der Realität gewonnen Erkenntnissen veröffentlichen. Der Artikel bietet Information auf hohem Niveau ! Danke

Vielen Dank für das Feedback. Leider können wir nur die Ergebnisse aus dem Pretest zeigen.